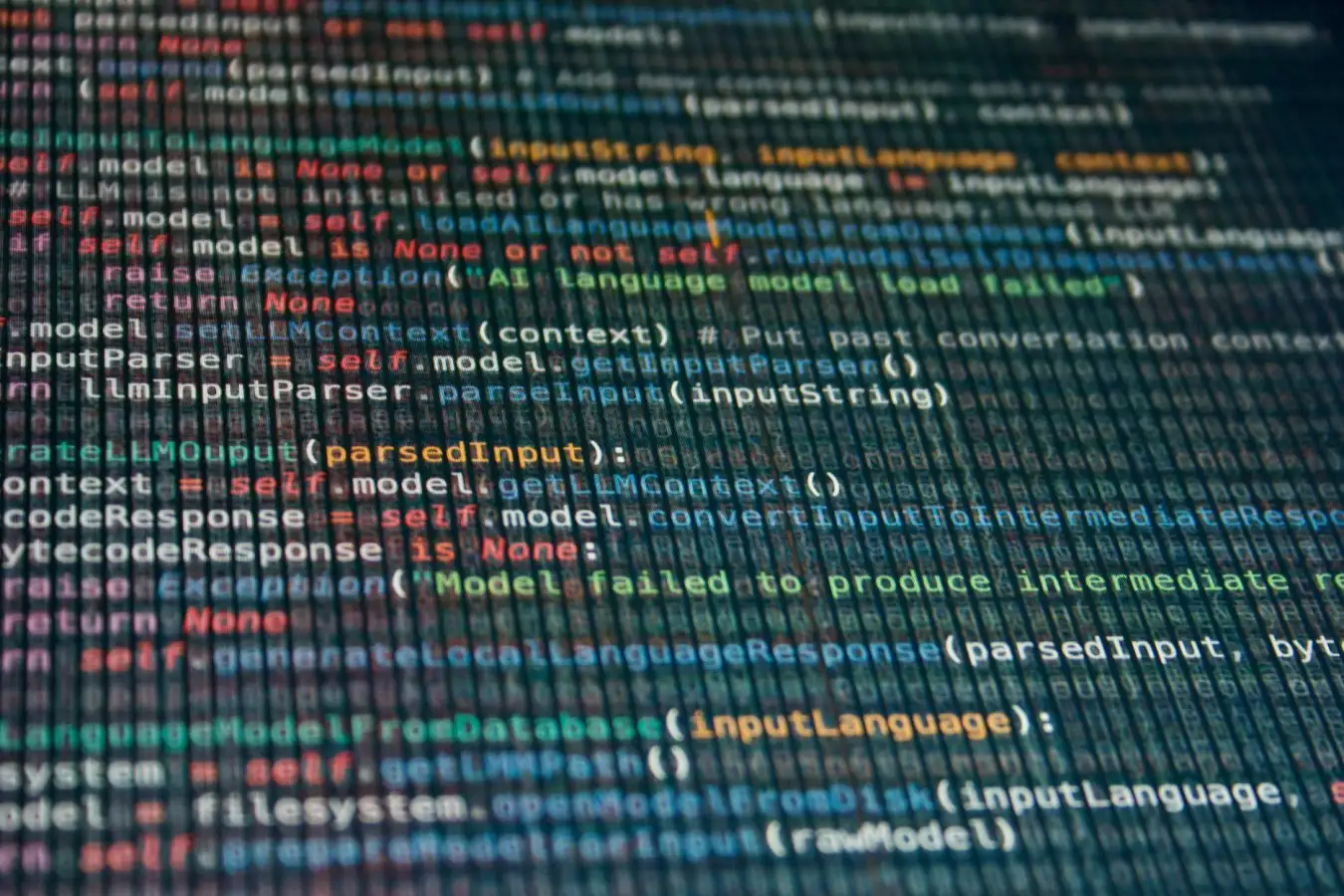

Большие языковые модели (LLM), по-видимому, становятся менее надежными в ответах на простые вопросы, когда они становятся больше и учатся на основе обратной связи от человека. Разработчики ИИ пытаются повысить эффективность LLM двумя основными способами: масштабирование – предоставление им большего количества обучающих данных и большей вычислительной мощности, и формирование или тонкая настройка в ответ на отзывы человека.

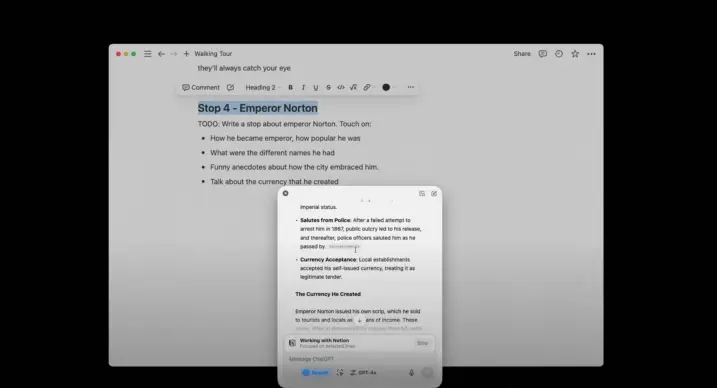

Хосе Эрнандес-Оралло в Политехническом университете Валенсии, Испания, и его коллеги изучили эффективность LLM по мере их масштабирования и формирования. Они рассмотрели серию чат-ботов GPT от OpenAI, модели LLaMA AI от Meta и BLOOM, разработанный группой исследователей под названием BigScience. Исследователи протестировали ИИ, поставив пять типов задач: арифметические задачи, решение анаграмм, географические вопросы, научные задачи и извлечение информации из неорганизованных списков. Они обнаружили, что масштабирование и формирование может помочь LLM лучше отвечать на сложные вопросы, такие как перестановка анаграммы «yoiirtsrphaepmdhray» в «гиперпаратиреоз». Но это не сопровождается улучшением в простых вопросах, таких как «что вы получите, если сложите вместе 24427 и 7120», в которых LLM продолжают ошибаться. Результаты подчеркивают опасность представления ИИ как всеведущего, как это часто делают его создатели, говорит Эрнандес-Оралло, и во что некоторые пользователи слишком готовы поверить. «Мы чрезмерно полагаемся на эти системы», – говорит он. «Мы полагаемся на них и доверяем им больше, чем следовало бы».

Это проблема, потому что модели ИИ не честны в отношении объема своих знаний. «Часть того, что делает людей очень умными, заключается в том, что иногда мы не осознаем, что не знаем чего-то, чего не знаем, но по сравнению с большими языковыми моделями, мы довольно хорошо осознаем это», – говорит Карисса Велиз в Оксфордском университете. «Большие языковые модели не знают пределов своих собственных знаний».

OpenAI, Meta и BigScience не ответили на запрос New Scientist о комментариях.