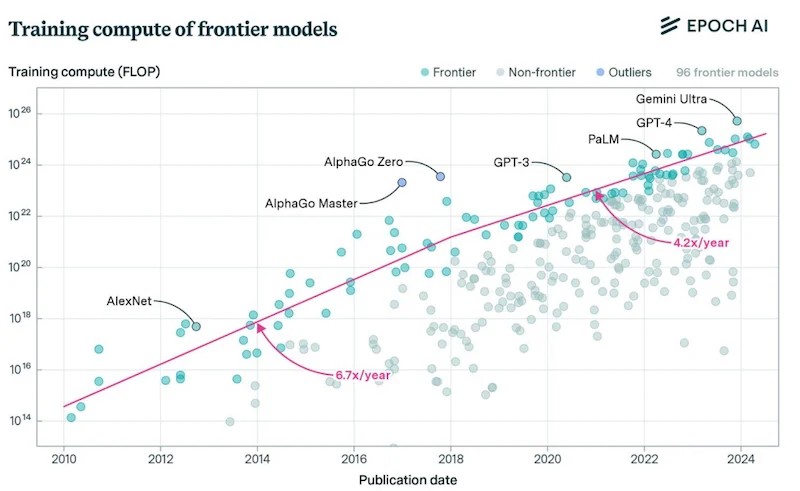

В то время как основной целью процесса разработки языковых моделей было повышение точности и актуальности результатов генеративного искусственного интеллекта в LLM, OpenAI получила значительное представление о потребностях в аппаратной инфраструктуре. OpenAI проводила эксперименты, чтобы определить, какой уровень вычислительной нагрузки требуется и каковы будут результаты при увеличении вычислительных мощностей. Они обнаружили предсказуемость требований к вычислениям на основе желаемой точности и коэффициентов энтропии. Если посмотреть на это с другой стороны, модель GPT-1 была обучена на одном устройстве с небольшой группой графических процессоров в течение нескольких недель. GPT-2 уже использовал кластер из 10 000 процессоров Nvidia V100 с тензорными ядрами.

OpenAI использует эти данные, чтобы оправдать большие инфраструктурные ставки на свою исследовательскую программу. Это также привело к обеспокоенности команды по поводу способности индустрии чипов удовлетворить аппаратные потребности OpenAI и индустрии искусственного интеллекта в целом. И дело не только в процессорах. Все другие многочисленные компоненты также должны быть доступны. С такой большой вычислительной мощностью, сосредоточенной в серверных фермах, потребление электроэнергии ИИ становится фактором первого порядка в общей электросети. Это становится всё большей проблемой. Синхронизированное обучение в центре обработки данных приведет к резкому снижению энергопотребления. Сегодняшняя сеть учитывает модели домашнего и промышленного использования, но не обязательно пиковую нагрузку на центр обработки данных.

Производительность компьютера также не является второстепенной по отношению к мощности, безопасности, сети и надежности. Эти дополнительные факторы находятся в равных условиях. Все они нуждаются в согласованных усилиях по расширению, особенно в области электросети и безопасности. «Мы считаем, что миру нужно развитие инфраструктуры – производственных мощностей, энергии, центров обработки данных и т. д. – чем люди в настоящее время планируют построить», — сказал Сэм Альтман, основатель OpenAI. «Создание крупномасштабной инфраструктуры искусственного интеллекта и устойчивой цепочки поставок имеет решающее значение для экономической конкурентоспособности».

OpenAI может взимать меньшую плату по мере роста возможностей LLM, а интеллектуальные и выходные уровни ИИ могут значительно вырасти. Однако вычислительная нагрузка работает в обратном направлении, а отраслевые фабрики и возможности разработки не поспевают за ними. Индустрия искусственного интеллекта нуждается в значительной новой инфраструктуре для создания чипов и поддержки цепочки поставок. Алгоритмы есть, но OpenAI обеспокоена тем, что аппаратное обеспечение станет основным ограничением, если отрасль в целом не предпримет четких действий. Масштабирование вычислительной инфраструктуры поддается проверке и предсказуемо. Растущий интеллект стимулирует спрос на логические выводы. Технологии и экономика искусственного интеллекта готовы к работе, недостающим кусочком головоломки является промышленная инфраструктура.

Источник: https://www.allaboutcircuits.com/news/trevor-cai-talks-ai-hardware-scaling-at-hot-chips-2024/

Если вам понравился материал, кликните значок - вы поможете нам узнать, каким статьям и новостям следует отдавать предпочтение. Если вы хотите обсудить материал - не стесняйтесь оставлять свои комментарии : возможно, они будут полезны другим нашим читателям!