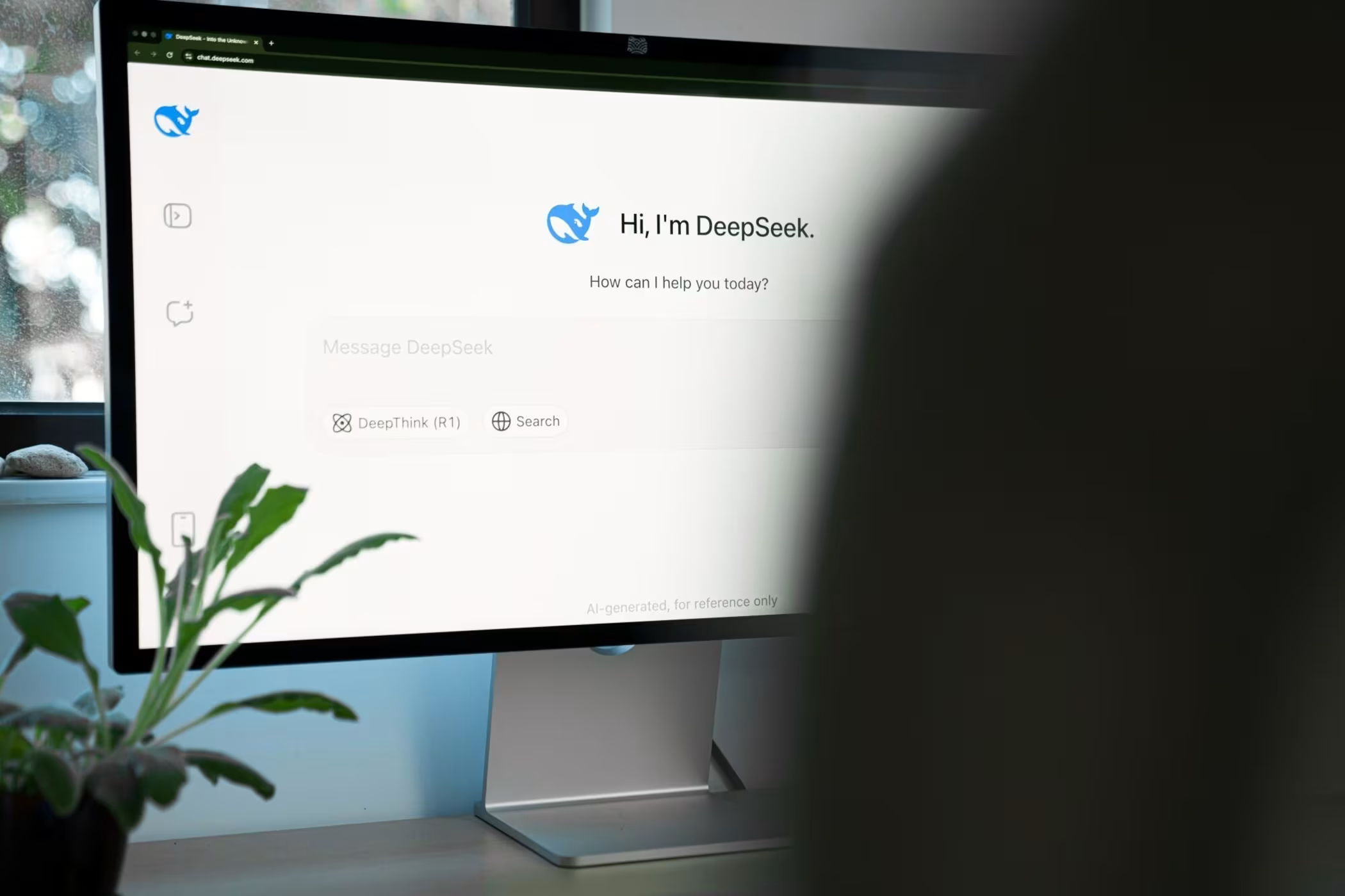

Компания заявляет, что модель демонстрирует результаты, сравнимые с моделью моделирования рассуждений (SR) OpenAI o1 в ряде математических тестов и задач программирования.

Помимо выпуска базовых моделей DeepSeek-R1-Zero и DeepSeek-R1, DeepSeek также представил шесть уменьшенных версий «DeepSeek-R1-Distill» с количеством параметров от 1,5 до 70 миллиардов. Эти дистиллированные модели основаны на существующих открытых архитектурах, таких как Qwen и Llama, и обучены на данных, полученных из полной версии R1. Самая компактная версия способна работать на обычном ноутбуке, тогда как полная модель требует значительно более мощных вычислительных ресурсов.

Эти релизы мгновенно привлекли внимание сообщества разработчиков ИИ, ведь большинство существующих моделей с открытыми весами, которые обычно можно запустить и настроить на локальных системах, уступают проприетарным моделям, таким как o1 от OpenAI, в так называемых логических тестах. Возможность использования таких функций в модели, лицензированной по лицензии MIT, доступной для изучения, модификации и коммерческого применения любым пользователем, потенциально открывает новые перспективы для общедоступных моделей ИИ.

«Они удивительно интересны в управлении, наблюдение за тем, как они мыслят, доставляет удовольствие», — поделился независимый исследователь ИИ Саймон Уиллисон в беседе с Ars. Уиллисон протестировал одну из меньших моделей и подробно описал свой опыт в своем блоге: «Каждый ответ начинается с псевдотега <думаю>... </думать>, содержащего цепочку размышлений, использованную для формирования ответа», отметив, что даже для простых запросов модель создает развернутые внутренние рассуждения перед формированием окончательного результата.

Модель R1 отличается от стандартных больших языковых моделей (LLM), поскольку использует подход, известный как симуляция рассуждений во время выполнения задачи. Она пытается воспроизвести человеческие мыслительные процессы при обработке запроса. Этот класс моделей, называемый моделями симуляции рассуждений (SR), впервые получил широкое признание, когда OpenAI представила своё семейство моделей o1 в сентябре 2024 года. В декабре OpenAI анонсировала значительное обновление под названием «o3». В отличие от обычных LLM, модели SR требуют больше времени для генерации ответов, и это дополнительное время зачастую улучшает производительность в задачах, связанных с математикой, физикой и естественными науками. Новая открытая модель DeepSeek вызывает особый интерес, так как, судя по всему, быстро приближается к достижениям OpenAI.

DeepSeek утверждает, что их модель R1 обошла o1 от OpenAI в нескольких тестах и бенчмарках, включая AIME (тест на математическое мышление), MATH-500 (набор словесных задач) и SWE-bench Verified (оценочный инструмент для программирования). Как всегда, к результатам тестов ИИ следует подходить с осторожностью, и эти данные требуют независимой проверки.

TechCrunch сообщает, что три китайские лаборатории — DeepSeek, Alibaba и Kimi от Moonshot AI — выпустили модели, которые, по их заявлениям, достигли уровня производительности o1, причем DeepSeek впервые представил R1 в ноябре.

Однако у облачной версии модели DeepSeek есть одно ограничение: будучи разработанной в Китае, R1 избегает обсуждения определенных тем, таких как площадь Тяньаньмэнь или статус Тайваня, следуя требованиям китайского интернет-регулирования, которые диктуют соблюдение «основных социалистических ценностей». Эта фильтрация осуществляется дополнительным слоем модерации, который не представляет проблем при локальной эксплуатации модели вне Китая.

Несмотря на возможные ограничения, исследователь ИИ из Университета Джорджа Мейсона Дин Болл отметил на X: «Производительность дистиллированных моделей DeepSeek (уменьшенные версии R1) впечатляет, и это значит, что мощные возможности рассуждений будут доступны повсеместно, работая на локальном оборудовании, вне контроля каких-либо внешних регуляторов».

Источник: https://arstechnica.com/ai/2025/01/china-is-catching-up-with-americas-best-reasoning-ai-models/

Если вам понравился материал, кликните значок - вы поможете нам узнать, каким статьям и новостям следует отдавать предпочтение. Если вы хотите обсудить материал - не стесняйтесь оставлять свои комментарии : возможно, они будут полезны другим нашим читателям!